Firecrawl – KI-gestütztes Web-Crawling und -Scraping innerhalb von Latenode

Firecrawl – KI-gestütztes Web-Crawling und -Scraping innerhalb von Latenode

Wenn Ihre Automatisierungen auf dem Sammeln von Live-Webdaten beruhen, Feuerkrabbler ist Ihr neues Lieblingstool in Latenode.

Es handelt sich um eine schnelle, zuverlässige und entwicklerfreundliche Web-Crawling- und Scraping-Engine – jetzt mit vollem Funktionsumfang verfügbar. No-Code- und API-Integration.

Von der Indexierung ganzer Websites bis hin zur Extraktion strukturierter Daten von einer einzelnen Seite – Firecrawl ermöglicht es Ihren KI-Agenten sehen Das Web – und nutzen Sie es als dynamische Datenquelle für Forschung, Analyse und Automatisierung.

Was Firecrawl macht

Firecrawl wurde entwickelt, um das offene Web in strukturierte, maschinenlesbare Daten umzuwandeln, die Sie überall innerhalb Ihrer Latenode-Flows verwenden können.

Es kombiniert umfassende Crawling-Funktionen mit gezieltem Scraping und intelligenter Site-Kartierung – alles visuell verbunden durch Drag-and-Drop-Knoten.

In der Praxis bedeutet das, dass Sie Folgendes können:

- Durchforsten Sie jede beliebige Domain und kartieren Sie deren gesamte Struktur.

- Produktdetails, Metadaten oder Kontaktinformationen von Webseiten extrahieren.

- Erstellen Sie dynamische Datensätze, die automatisch auf dem neuesten Stand bleiben.

- Spleißen Sie Live-Webdaten in LLMs, RAG-Systeme oder Dashboards ein.

Keine Proxys. Keine manuelle Datenanalyse. Nur saubere, strukturierte Daten, bereit für Ihre Automatisierungen.

Firecrawl-Knoten in Latenode

Firecrawl wird mit einem Set geliefert speziell entwickelte Knoten die jede Phase der Webdatenerfassung abdecken – von der Entdeckung von Seiten bis hin zur Gewinnung von Erkenntnissen.

| Knoten | Beschreibung |

|---|---|

| Crawl-URL | Starten Sie einen vollständigen Crawl einer beliebigen Website oder Domain. Firecrawl folgt automatisch den Links und erstellt eine Seitenübersicht. |

| Ergebnis für Crawl-URL abrufen | Die strukturierten Daten (JSON) eines abgeschlossenen Crawls, einschließlich aller gefundenen URLs und Metadaten, werden abgerufen. |

| Karten-Website | Erstellen Sie eine Sitemap der internen Links und der Seitenhierarchie – perfekt für SEO-Analysen oder die Vorbereitung von groß angelegten Web-Scraping-Projekten. |

| Website auslesen | Extrahieren Sie spezifische Daten (Text, Tabellen, Metadaten) aus einer gegebenen URL oder einer Gruppe von Seiten. |

| Suche Website | Führen Sie innerhalb einer durchsuchten Domain schlüsselwort- oder musterbasierte Suchen durch, um bestimmte Themen, Seiten oder Datenpunkte zu finden. |

Jeder Knoten kann unabhängig oder nacheinander ausgeführt werden – so haben Sie eine detaillierte Kontrolle darüber, was erfasst und wie es verwendet wird.

Warum Firecrawl wichtig ist

Vor Firecrawl bedeutete das Sammeln von Webdaten, mit Tools, Proxys und Skripten zu jonglieren.

Jetzt können Sie alles visuell innerhalb von Latenode erledigen – und diese Daten direkt in Ihre Automatisierungslogik, KI-gestützte Schlussfolgerungen oder Analyseplattform einbinden.

Vorteile:

- ⚡ Schnelligkeit - Crawling und Scraping werden schneller abgeschlossen als mit herkömmlichen Skripten.

- 🧠 KI-nativ - Konzipiert für RAG, Datenanreicherung und Multiagenten-Workflows.

- 🔒 Zuverlässig - Verarbeitet dynamische Websites, Weiterleitungen und Paginierung automatisch.

- 🧩 Zusammensetzbar - Kombinieren Sie es mit der Logik, der API oder den KI-Knoten von Latenode, um autonome Datensysteme zu erstellen.

Egal ob Sie einen KI-gestützten SEO-Monitor, ein Tool zur Wettbewerbsanalyse oder einen Datensatzgenerator entwickeln – Firecrawl macht Daten im Webmaßstab für alle zugänglich.

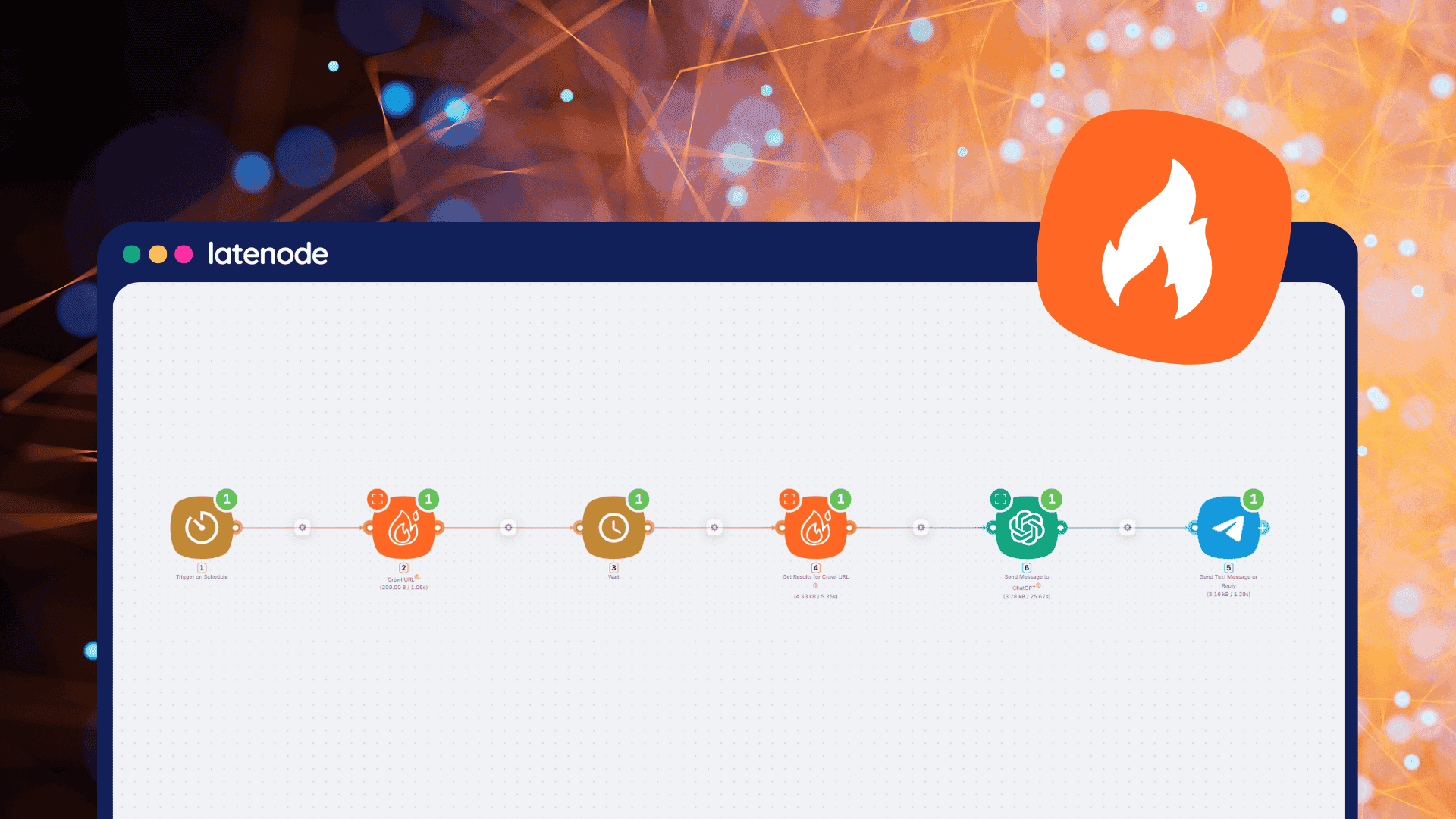

Anwendungsfall: Automatisierte Webdatenüberwachung mit Firecrawl und Telegram

Erstellen Sie ein automatisiertes System, das regelmäßig strukturierte Informationen von beliebigen Websites sammelt. Firecrawls KI-gesteuerte Extraktions-Enginesendet dann übersichtliche, formatierte Zusammenfassungen an Telegram für schnelle, tägliche Einblicke.

Erstellen Sie eine einfache Automatisierung, die Folgendes überprüft: aktuelle Preispläne auf Latenode.comDie Informationen werden mithilfe von ChatGPT in eine übersichtliche Zusammenfassung formatiert und direkt an einen Telegram-Kanal übermittelt.

Funktionsweise

- Auslösen nach Zeitplan

- Der Workflow wird automatisch zu einem festgelegten Zeitpunkt ausgeführt – beispielsweise einmal täglich –, um die Preisinformationen auf dem neuesten Stand zu halten.

- Crawl-URL (Firecrawl)

- Firecrawl kriecht die Latenode-Preisseite und extrahiert strukturierte Daten wie Tarifnamen, Preise und Details.

- Warteknoten

- Fügt eine kurze Verzögerung hinzu, um sicherzustellen, dass Firecrawl die Verarbeitung abschließt, bevor die Ergebnisse abgerufen werden.

- Ergebnisse für Crawl-URL abrufen (Firecrawl)

- Ruft die extrahierten Daten im strukturierten JSON-Format ab, das alle Preispläne und deren Beschreibungen enthält.

- Nachricht an ChatGPT senden

- Die JSON-Ausgabe wird an ChatGPT weitergeleitet, das die Rohdaten in eine übersichtliche, lesbare Zusammenfassung umwandelt, die für Telegram geeignet ist – wobei jeder Tarif, seine Kosten und die wichtigsten Funktionen hervorgehoben werden.

- Nachricht an Telegram senden

- Die formatierte Zusammenfassung wird automatisch an einen Telegram-Chat oder eine Gruppe gesendet, sodass Sie (oder Ihr Team) immer die aktuellsten Latenode-Preisinformationen zur Hand haben.

![]()

👉 Beginnen Sie mit diesem Projekt. Vorlage.

Was es bietet

Diese Konfiguration dient als täglicher Datenintelligenzagent dass:

- Sammelt Echtzeit-Updates von jeder öffentlichen Webseite.

- Extrahiert nur die von Ihnen definierten Datenpunkte.

- Automatisches Warten und Wiederholen

- Liefert Erkenntnisse direkt an Telegram in Sekundenschnelle

Beispiel in Aktion

Eingang:

Ziel-URL: /pricing-plans

Prompt: „Alle Preispläne als Array extrahieren, einschließlich Plannamen, Preise und Details.“

Schema:

Endergebnis:

![]()

Zusätzliche Beispiele

Ein Marketingteam nutzt diesen Workflow, um Preisänderungen und Verfügbarkeit verfolgen für Produkte von Mitbewerbern.

Firecrawl ruft jeden Morgen aktualisierte Produktdaten ab, strukturiert diese und sendet eine Zusammenfassung an Telegram.

Wenn das Team mit seinem Arbeitstag beginnt, hat es bereits eine Momentaufnahme davon, was sich über Nacht verändert hat.

Zu den weiteren gängigen Anwendungen gehören:

- Überwachung Krypto- oder Finanz-Dashboards

- Kratzen neue Stellenanzeigen oder Veranstaltungsankündigungen

- Tracking Veröffentlichungen von Regulierungsdaten oder Pressemitteilungen

Ergebnis

Am Ende erhält man ein zuverlässiges KI-gestütztes Datenüberwachungssystem dass:

- Läuft automatisch nach Zeitplan

- Extrahiert strukturierte Informationen von beliebigen Webseiten.

- Formatiert es für schnelles Lesen

- Sendet die Ergebnisse direkt dorthin, wo Sie sie benötigen.

Alles wird unterstützt von Firecrawls Extraktionsinformationen und Automatisierungslogik von Latenode — Wir verwandeln täglich unstrukturierte Webseiten in umsetzbare Erkenntnisse.

Sofortiger Zugriff mit PnP-Tokens

Wie alle nativen Latenode-Integrationen, Feuerkrabbler Erfordert keine Schlüssel oder Einrichtung.

- Keine externen Konten.

- Keine manuellen Konfigurationen.

- Just PnP-Token - einstecken, loslegen und kriechen.

Mit PnP-Tokens können Sie API-Aufrufe auslösen, Daten abrufen und KI-Agenten ausführen – alles über ein einziges einheitliches Guthaben.

Das bedeutet, dass Sie Firecrawl sofort in Ihre Arbeitsabläufe integrieren und innerhalb von Minuten mit der Erfassung von Live-Webdaten beginnen können.

Erstellen Sie Ihren ersten Webcrawler in Latenode

Firecrawl macht das offene Web so programmierbar wie eine API.

Sie können jetzt Agenten erstellen, die Daten durchsuchen, extrahieren und analysieren – alles innerhalb einer einzigen visuellen Umgebung.

Probieren Sie Arbeitsabläufe wie die folgenden:

- Blog-Inhalte wöchentlich mit GPT durchsuchen und zusammenfassen.

- Produktlisten von Konkurrenzseiten in Notion oder Airtable einpflegen.

- Suchen und analysieren Sie FAQ-Seiten nach spezifischen Themen oder Erwähnungen.

👉 Beginnen Sie mit Firecrawl auf Latenode mehr Informationen.

Verwandeln Sie jede Website in strukturierte, durchsuchbare Daten – und machen Sie Ihre Automatisierungen intelligenter als je zuvor.